在数字化的浪潮中,“信息”这一概念已从抽象的理论术语,演变为驱动社会与科技进步的核心资源。它通常被理解为经过组织、处理并赋予意义的数据,能够减少不确定性,支持决策与知识创造。而在学术研究的前沿,特别是数据密集型科学领域,一种新兴的出版物形式——“数据论文”正日益凸显其价值。这为我们深入探讨信息从原始数据到可重用知识的完整生命周期,提供了一个绝佳的视角。本文将聚焦于数据论文的背景,并深入剖析其中至关重要的数据分析与数据处理环节。

一、背景:数据论文的兴起与信息价值升华

数据论文是一种专门用于描述特定数据集的学术出版物,其核心目的并非提出新理论或验证假设,而是详尽、规范地展示数据本身——包括其采集方法、处理流程、质量控制、结构格式以及潜在的应用价值。它的兴起有着深刻的背景:

- 数据爆炸与可重复性危机:科学研究正产生海量数据,但许多研究中的数据并未得到有效共享或规范化描述,导致研究成果难以复现和验证。数据论文通过提供“数据文档”,旨在提升研究的透明度、可重复性与可信度。

- 开放科学运动的推动:开放获取、开放数据成为学术界的共识。数据论文鼓励研究者将数据作为独立的研究成果公开发布,使其能够被同行发现、引用和再利用,从而加速科学发现的进程。

- 数据即资产:在诸多领域(如基因组学、天文学、气候科学),高质量的数据集本身具有极高的长期价值。数据论文为数据生产者提供了正式的学术认可(通过引用),将数据提升为与学术论文同等重要的科研产出。

在此背景下,数据论文本身成为了一种高度结构化的“信息载体”,它将原始数据(Raw Data)转化为富含上下文、可信且可操作的“信息包”。

二、核心环节一:数据处理——从原始到可用的基石

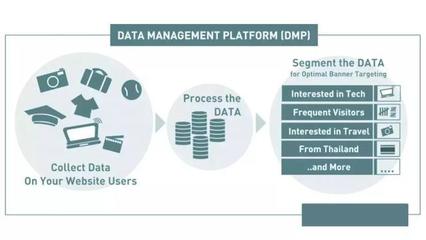

数据处理是信息生命周期的第一步,也是数据论文描述的基石。它指的是对收集到的原始数据进行的一系列技术操作,旨在将其转化为适合分析的、整洁的格式。在数据论文的语境中,数据处理环节必须被清晰、透明地记录,主要内容包括:

- 数据清洗:识别并纠正或删除数据中的错误、不一致、重复项和缺失值。这是确保数据质量的关键,直接决定了后续分析结果的可靠性。

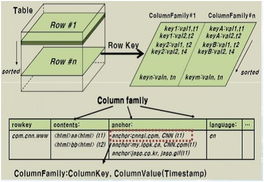

- 数据转换:将数据转换为统一的格式或结构。例如,标准化单位、统一编码系统(如将文本分类转换为数字代码)、数据归一化或聚合。

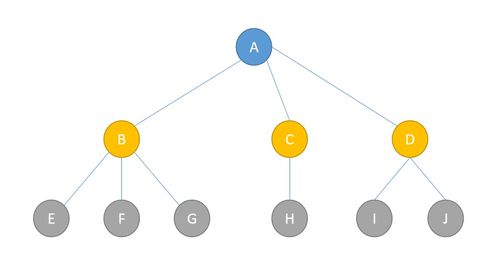

- 数据集成:当数据来自多个源头时,需要将其合并、关联,并解决模式冲突,形成一个一致的数据集。

- 数据脱敏与匿名化:对于涉及个人隐私或敏感信息的数据,必须通过技术手段移除或加密标识符,以符合伦理和法律要求。

数据处理的目标是产出“清洁数据”。一份优秀的数据论文会详细说明所使用的软件工具、算法参数、处理步骤以及任何关键决策的理由,使其他研究者能够完全理解甚至复现数据处理流程。

三、核心环节二:数据分析——从数据到见解的飞跃

数据分析是继数据处理之后,从清洁数据中提取有价值信息、形成初步见解的过程。在数据论文中,数据分析的目的通常不是为了得出一个特定的研究结论,而是为了:

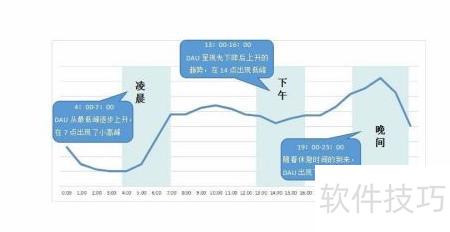

- 评估数据质量与基本特征:通过描述性统计分析(如均值、标准差、分布可视化)、数据探查(EDA)来展示数据集的基本面貌,让潜在用户了解其概况、范围和局限性。

- 验证数据的有效性与一致性:通过简单的分析检查数据内部逻辑是否自洽,或与已知事实是否相符。

- 揭示数据的潜在模式与价值:进行初步的探索性分析,如图表、相关性分析等,以提示该数据集可能支持的研究方向和应用潜力。

例如,一份关于全球气候站点的数据论文,其数据分析部分可能包括绘制多年温度趋势图、计算各区域的平均降水量、分析不同变量间的相关性等。这些分析结果本身不构成新的气候理论,但能有力证明该数据集在气候研究中的可用性和价值。

四、数据处理与分析的协同:构建可信的信息链

在数据论文的框架内,数据处理与数据分析并非孤立环节,而是紧密衔接、相互印证的协同过程。

- 处理为分析奠基:高质量的数据处理是任何有意义分析的前提。混乱的原始数据会导致“垃圾进,垃圾出”的分析结果。

- 分析验证处理效果:数据分析(尤其是描述性统计和可视化)是检验数据处理效果的有效工具。通过分析结果,可以发现数据处理中可能残留的异常或偏差。

- 共同支撑信息可信度:透明公开的处理与分析步骤,构成了数据论文信息可信度的证据链。读者可以追溯从原始数据到最终呈现信息的每一步,从而建立起对数据集本身的信任。

结论

在数字时代的信息观照下,数据论文代表了信息管理的前沿实践。它将“信息”的概念具体化为一个经过精心加工、有据可查、可供共享的数据产品。其中,数据处理是赋予数据可用性的技术骨架,数据分析则是初步展现数据价值的信息窗口。二者在数据论文的规范描述下有机结合,共同完成了将原始数字数据升华为可发现、可理解、可重用、可信赖的科研信息的关键转化。这不仅推动了开放科学的发展,也深化了我们对于“信息”作为现代科学基石的理解——它不仅是结论,更是支撑未来无数结论的、经过严谨制备的原材料与基础设施。