在信息爆炸的时代,海量数据处理已成为企业运营和科学研究的核心挑战。传统的单机系统在存储和计算能力上均难以应对TB乃至PB级别的数据洪流。在此背景下,以Hadoop为代表的分布式计算框架与MapReduce编程模型应运而生,为我们提供了一套系统性的解决方案,深刻改变了数据处理的技术图景。

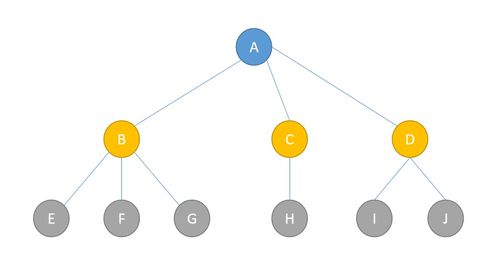

Hadoop框架的核心优势在于其分布式架构。它主要由两大基石构成:分布式文件系统HDFS(Hadoop Distributed File System)和分布式计算模型MapReduce。HDFS的设计哲学是将大文件分割成固定大小的数据块,并分散存储于集群中大量廉价的商用服务器节点上。这种设计不仅实现了极高的存储容量和可靠性(通过多副本冗余机制),更关键的是,它将计算任务“移动”到数据所在的节点,从而避免了大规模数据在网络中的迁移,极大地减少了I/O开销,这是处理海量数据时提升效率的关键。

而MapReduce模式,则是驾驭这种分布式存储系统的计算引擎。它将复杂的数据处理任务抽象为两个简洁而强大的阶段:Map(映射)和Reduce(归约)。在Map阶段,输入数据被分割成独立的片段,由集群中的多个节点并行处理,生成一系列中间键值对。在Reduce阶段,系统将相同键的中间结果汇集到同一节点进行合并与汇总,最终产生输出结果。这种“分而治之”的思想,完美契合了分布式集群的并行计算能力。程序员只需关注Map和Reduce两个函数的业务逻辑,而诸如任务调度、节点通信、故障容错(某个节点失效后任务会自动重新调度)等复杂的分布式系统问题,均由框架透明处理,极大地降低了开发门槛。

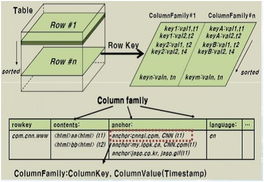

将Hadoop与MapReduce结合,海量数据处理的流程变得清晰高效。例如,分析数十亿条网页日志以统计用户访问模式:HDFS负责可靠地存储这些原始日志文件;MapReduce作业首先启动多个Map任务,每个任务并行处理一部分日志,提取出(用户ID,访问页面)这样的键值对;然后,框架将所有相同用户ID的记录“洗牌”(Shuffle)到同一个Reduce任务中,该任务便可轻松统计出每个用户的访问总次数或页面序列。整个过程可以线性扩展至数千个节点,处理时间并不随数据量倍增而线性增加。

技术范式也在不断演进。经典的MapReduce模型因其多步磁盘I/O(Map和Reduce间需落盘)在迭代计算(如机器学习)和实时查询场景中存在延迟瓶颈。这催生了Hadoop生态的繁荣与进化,如引入YARN作为统一的资源调度器,以及诞生了Spark这样基于内存计算、DAG执行引擎的替代框架。Spark扩展了“Map”和“Reduce”的操作集合,提供了更丰富的转换算子,并在内存中尽可能保留中间结果,使得某些场景下的性能提升了一个数量级。

但无论如何演进,Hadoop与MapReduce所奠定的思想基础——通过分布式存储与并行计算来分解海量数据问题,通过高层抽象来屏蔽系统复杂性——依然是当今大数据处理领域的灵魂。它们不仅是一套技术工具,更是一种应对数据洪流的系统性方法论。从HDFS的“移动计算而非数据”,到MapReduce的“分治与归约”,这些核心智慧持续引导着我们设计更高效、更稳健的数据处理系统,以从浩瀚的数据海洋中挖掘出宝贵的知识与价值。